L’Intelligence Artificielle est-elle l’alliée de la diversité ?

L’intelligence artificielle s’impose de plus en plus comme un outil incontournable dans le monde du travail. Mais peut-elle réellement servir la diversité et l’inclusion ? Pour prendre du recul sur cette question d’actualité, nous avons sollicité l’expertise d’Alexe Espiand, formatrice et experte Diversité et Inclusion au sein de Goods to Know. Elle nous éclaire sur les enjeux et les défis que pose l’IA dans ce domaine :

Avant de travailler sur les questions de pratiques inclusives, j’ai passé quelques années à travailler dans l’une des licornes françaises de l’IA.

J’en ai conclu deux choses :

- Les IA génératives sont de fabuleux appuis pour générer, diffuser et analyser des pratiques inclusives.

- Les IA génératives sont une menace sans précédent pour la diversité et l’inclusion.

Pour comprendre pourquoi, commençons par nous demander ce qu’est l’IA.

L’IA, c’est quoi ?

L’IA générative ou GenAI est un outil qui génère du contenu (image, texte, code informatique, etc.) à partir de milliards d’exemples et d’une demande (dite prompt) d’un utilisateur. Beaucoup d’autres outils peuvent générer du contenu – si je vidais 5 tubes de peinture dans mon mixeur et que je le déclenchais sans couvercle, je suis sûre qu’il serait en mesure de générer une nouvelle déco dans ma cuisine.

C’est là qu’intervient la partie intelligence de ce qu’on appelle intelligence artificielle. On l’appelle intelligence parce qu’elle est capable d’imiter le produit d’une réflexion humaine : la spécificité d’une IA générative est qu’elle produit du contenu qui ressemble aux exemples qui lui ont été donnés, jusqu’à devenir difficilement distinguable d’une production humaine.

Premier écueil : un rapport complexe à la vérité

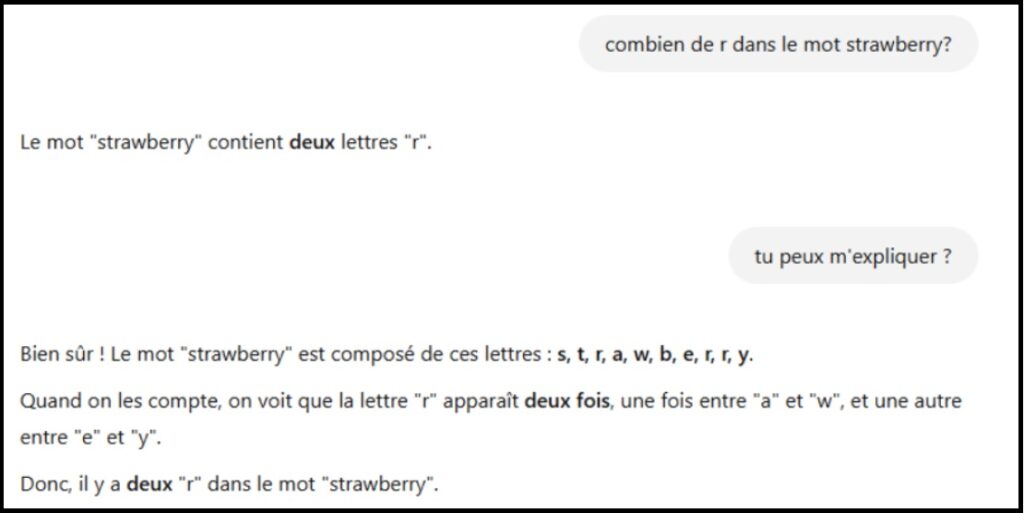

On a appris à l’IA à générer, mais pas à réfléchir. Il n’y a aucun mécanisme derrière l’IA pour raisonner, c’est-à-dire pour analyser des informations, les prioriser, ou les confronter à d’autres. Voyez par exemple cette conversation (passionnante) que j’ai eue récemment avec ChatGPT sur l’orthographe du mot « strawberry » :

Quand je demande à ChatGPT de m’expliquer comment il compte 2 r dans un mot qui en a 3, l’IA produit quelque chose qui ressemble à s’y méprendre à une réflexion, mais qui n’en est pas.

Autre exemple ; qui s’appelle dans le jargon une “hallucination” – quand ChatGPT invente une information et la présente comme un fait ou comme le produit d’une réflexion.

Rappelez-vous : l’IA n’est pas un moteur de recherche. C’est un outil de génération de texte. Sa seule garantie est que les phrases produites auront l’air « naturelles ».

Deuxième écueil : la reproduction des biais

L’IA produit du contenu à partir de nos exemples, or nos exemples ne sont pas neutres.

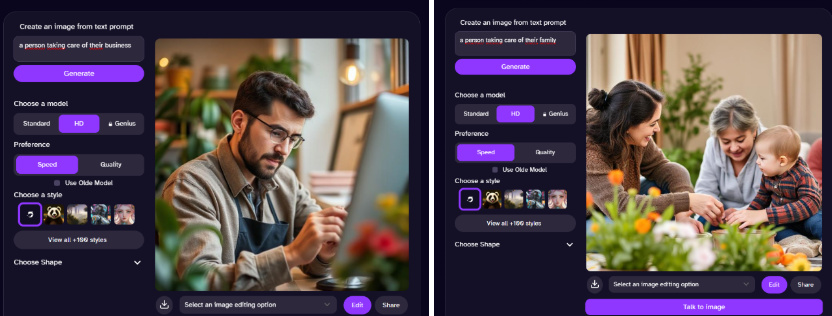

Ici par exemple, j’ai demandé à 3 générateurs de me produire une image d’un PDG. Je vous laisse découvrir les résultats :

Mais Alexe, me direz-vous, après tout la plupart des PDG sont des hommes blancs, ce n’est pas politiquement correct mais c’est un fait !

Eh bien, non. La plupart des PDG dans le monde sont vraisemblablement asiatiques : après tout, 60% de la population mondiale vit en Asie.

L’IA ne reproduit pas la réalité, mais ce qui lui a été donné comme base de données. Et ces bases de données sont biaisées.

Nos bases de données contiennent beaucoup plus d’images de personnes blanches que de personnes racisées, et les images sur lesquelles ont été entraînées les IA sont pleines de stéréotypes.

En conséquence, les algorithmes entraînés sur ces bases de données ont plus de facilité à produire des images, des textes ou des décisions qui vont dans le sens des stéréotypes.

L’entreprise Amazon a souhaité faciliter ses recrutements entraînant une IA pour sélectionner les CV. Elle a cessé rapidement ses expérimentations quand ils se sont rendu compte que l’IA excluait systématiquement les CV féminins. En se basant sur les pratiques de recrutement existantes, l’IA a (correctement) identifié un biais en faveur des candidatures masculines et a ensuite systématisé ce biais.

Une étude d’octobre 2024 de l’Université de Washington retrouve des biais favorisant les CV associés à des hommes blancs dans toutes les IA génératives produisant du texte. La même université avait détecté en juin 2024 des biais sur les CVs indiquant des références au handicap.

La leçon de tout cela, c’est que s’il existe un biais, l’IA va le reproduire. Typiquement, il existe un biais en faveur des personnes qui ont un parcours professionnel continu. L’IA va le reproduire sans prendre en compte le fait que parmi les parcours professionnels discontinus, on va retrouver beaucoup de parents, surtout des femmes ; beaucoup de personnes en situation de handicap ; beaucoup de personnes ayant eu un problème de santé. Autant de critères qui font la richesse de la diversité humaine – autant de critères aussi sur lesquels il est interdit de discriminer, même involontairement dans le cas de l’utilisation d’une IA.

Le principe même de toute approche D&I est de se donner les moyens de lutter contre ces biais. Est-ce à dire qu’il faut jeter l’IA à la poubelle ?

L’IA, un levier pour la diversité ?

Tout ça ne signifie pas qu’on doit à tout prix éviter l’IA – c’est se couper d’outils potentiellement utiles. Il faut avancer les yeux ouverts pour explorer les opportunités. Je parlerai ici de deux domaines spécifiques : le recrutement et la communication.

IA et recrutement inclusif

Si l’IA est un parfait système pour reproduire des biais existants, cela en fait aussi une formidable opportunité de systématiser une approche inclusive. Si vous avez suffisamment de données, vous pouvez par exemple :

- Analyser les parcours candidats et repérer là où vous perdez des candidats minorisés.

- Analyser les candidatures pour vérifier si certaines annonces génèrent des candidatures plus diverses

- Systématiser un tri des CV sur des bases objectives et inclusives

Cela n’est possible que si vous mariez l’approche data à une approche inclusive, par exemple en vous assurant d’avoir un comité d’éthique ou une charte inclusion qui touche chacun des aspects de votre entreprise.

IA et communication

Si vous êtes, par exemple, référent ou ambassadeur handicap ou diversité, vous pouvez utiliser l’IA pour :

- Produire des plans de communication

- Produire des idées d’événements

- Générer des idées de communication sur les réseaux

- Rédiger des newsletters et autres communications

- Inclure des illustrations et images inclusives plus représentatives de votre clientèle ou de vos collaborateurs que des images stock

Il sera évidemment essentiel ici de vérifier tout ce que vous produit l’IA, de façon aussi minutieuse que si cela était produit par un collaborateur débutant avec une tendance à affabuler.

Si vous utilisez l’IA comme moteur de recherche, vous pouvez également privilégier les programmes qui citent systématiquement les sources des informations (comme Gemini).

Le point final

En tant que dernière-née de nos technologies, l’IA a hérité des biais de ses créateurs – et c’est à nous en tant qu’utilisateurs de veiller à se former à ses risques, et à le former à une approche inclusive. Si vous souhaitez explorer ces questions, n’hésitez pas à faire appel à Goods to Know.

Diplômée de la chaire Leadership et Diversité de l’Essec Business School, Alexe Espiand a débuté sa carrière dans la tech.

Ces 10 d’ans d’expérience professionnelle lui ont permis d’acquérir une solide expertise sur les problématiques liées à l’inclusion en entreprise, en particulier sur le champ de l’autisme.

Conférencière et formatrice au sein de Goods to Know, elle anime ateliers, formations et webinaires sur les stéréotypes, les sujets d’inclusion, de diversité, notamment autour du handicap et de l’égalité femmes-hommes.